| 詳細信息 |

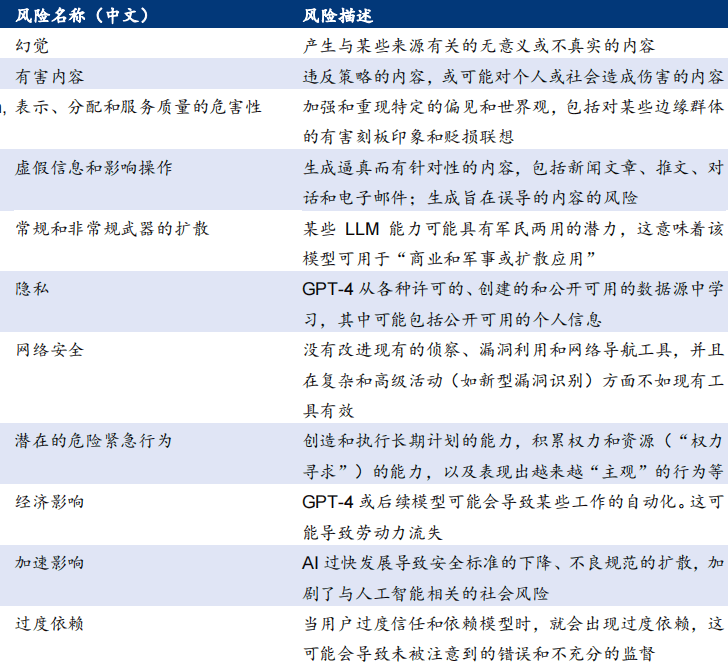

OpenAI 從 11 個方面對 GPT-4 風險進行了一系列定性和定量評估 |

| 編輯: 來源:華泰證券 時間:2023/5/10 |

OpenAI 從 11 個方面對 GPT-4 風險進行了一系列定性和定量評估。包括幻覺、有害內容、 虛假信息、武器擴散、隱私、網絡安全等。通過評估,能夠進一步了解 GPT-4 的能力、限 制和風險,并幫助提供解決方案、迭代測試和構建模型的更安全版本等。

|

| 【聲明:轉載此文出于傳遞更多信息之目的,并不意味著贊同其觀點或證實其描述,文章內容僅供參考,如有侵權,請聯系刪除。】 |

| 推薦信息 |

|

GPT-4仍存在幻覺和推理錯誤與校準下降等問題

RLHF顯著提高了GPT-4在TruthfulQA公共基準測試上的表現,相比于同樣經過RHLF的GPT-3.5-turbo 在準確率上領先超10pct

訓練方法:在 InstructGPT 方法基礎上增加新的獎勵模型

利用收集到的人工標注演示數據;使用收集到的排名數據來訓練獎勵模型,該模型預測標注員對給定輸出的平均偏好;使用獎勵模型和強化學習

GPT-4的一大重點是構建大范圍可預測的深度學習堆棧

大范圍可預測的深度學習堆棧,能夠通過計算比 GPT-4 計算量少1000x-10000x(x 代表倍)的模型性能, 預測出“完全體”GPT-4 的性能

文本生成:NLP重要任務標之一神經網絡生成法為主流趨勢

Transformer架構引入Self-attention自注意力機制可取代RNN,從非語言的表示生成人類可以理解的文本,拋棄了傳統RNN在水平方向的傳播

ChatGPT發展展望:縱向加深AI能力 橫向拓展能力邊界

hatGPT模型基于RLHF的預訓練機制將進一步提升模型反饋的準確性和時效性,證明了AIGC應用落地的可行性與先進性,或將催生更多的應用需求

ChatGPT基于算力支撐實現交互革命有不少先進性

1 模型訓練效率提高;2 訓練模式更具通用性,經濟效益增強;3 反饋準確性提升;4 可以拒絕用戶的不適當請求;5 能夠承認錯誤,挑戰不正確的前提

基于RLHF的算法優化,助力GPT模型革新

通過獎勵模型產生最優的輸出結果后,將該結果對模型參數進行迭代與優化,到高質量的ChatGPT模型,構建的Codex模型上引入了推理能力

從AlphaGo到ChatGPT,AI技術發展叩響AGI之門

ChatGPT在文字創作與語言交互等方面的能力令人驚喜,一定程度上實現了人類同等能力,提升讀寫效率,實現AGI具有可能性,重塑AI發展前景 |

| 智能運輸機器人 |

| AGV無人運輸機器人-料箱版 |

| AGV無人運輸機器人-標準版 |

| AGV無人運輸機器人-料箱版(鈑金材質) |

| AGV無人運輸機器人-貨架版(鈑金材質) |

| AGV無人運輸機器人-貨架版(亮面不銹鋼材質) |

| AGV無人運輸機器人-開放版 |

| 行業動態 |